- 1. Поддельные документы и фальшивые переводы

- 1.1. «Новый паспорт за одну минуту».

- 1.2. Фейковые чеки и квитанции.

- 1.3. «Деньги переведены – вот пуш-уведомление…»

- 2. Deepfake-звонки: от «Мама, помоги!» до видеочата с чиновником

- 2.1. «Мама, помоги мне!»

- 2.2. Дипфейк-клон в FaceTime: у китайского предпринимателя «друг» выманил миллионы.

- 2.3. «Видеозвонок» от мэра и генерала – афера на 2 млн.

- 2.4. «Мама, это я… срочно нужны деньги».

- 2.5. Имитация голосов сотрудников банка и полиции.

- 3. Атаки на бизнес: фальшивый босс, приказы ФСБ и виртуальные заложники

- 3.1. «Одолжите миллион – говорит директор».

- 3.2. Когда звонит «сам начальник» (Великобритания).

- 3.3. «Говорит ваш шеф…» в России.

- 3.4. Виртуальный «захват заложников».

- 3.5. «Атака на миллион по голосу директора».

- 4. Романтические аферы и LoveGPT

- 4.1. Фальшивые партнеры, созданные нейросетью.

- 5. Сексторшн и шантаж репутацией

- 5.1. «Порноподделки» для шантажа.

- 5.2. «Шантажист 2.0»: «Мы сфабрикуем доказательства против тебя».

- 6. Взлом аккаунтов и рассылка дипфейков друзьям

- 6.1. «Друзья, выручайте! Мне срочно нужны деньги!» – история с Алтая.

- 6.2. «Deepfake-друзья» в Туле.

- 7. Фишинг 2.0: письма и сообщения, которые пишет ИИ

- 7.1. Идеальные «официальные» письма.

- 7.2. Ловушки под видом «эксклюзивного доступа к ChatGPT»

- 8. Поддельные инвестиции и лжеуслуги под ИИ

- 8.1. «Илон Маск рекомендует…» – видео, которого не было.

- 8.2. Продажа фейковых акций DeepSeek.

- 8.3. Запретный AI-адвокат.

- 9. Мошенничество в туризме: липовые отели и бронирования

- 9.1. Фейковые гостиницы с AI-фотографиями.

- Что в итоге?

Не проходит и недели, чтобы не увидеть печальный заголовок вроде «Человек отдал мошенникам крупную сумму денег». На уловки попадаются уже не только люди пожилого возраста, но и в целом осознанные граждане. Почему так происходит? Мы всё еще люди, и на нас можно воздействовать и убедить в чем угодно – в этом и сила, и слабость Homo sapiens.

В последние годы мошенники всё активнее применяют целый спектр технологий на базе искусственного интеллекта (ИИ), чтобы создавать реалистичные подделки и обманывать людей. Но проблема в том, что даже при огромном хайпе нейросетей в последние годы большинство населения не слышало про них и даже не подозревает, с какой точностью и реалистичностью фотография и голос могут быть подделаны.

Ниже – краткий ликбез об основных технологиях, используемых в мошеннических схемах.

1. Генерация изображений.

При помощи специальных алгоритмов и приложений можно сделать фотографию с нужным лицом в любом амплуа. Для этого нужно загрузить всего 5–10 фотографий, система анализирует фото, запоминает очертания лица, прическу, глаза, и далее надо только описать, где и как будет этот персонаж. Если ранее такие системы были дорогостоящие и качество было посредственным, теперь это стоит 5 долларов, и на экране телефона вы не всегда отличите фейк.

20 000 лайков, множество комментариев, мы листаем ленту и радуемся за человека, бегло посмотрев на фото. А теперь посмотрите на руку.

2. Голосовые дипфейки (Voice Cloning).

Современные модели могут за считаные секунды «научиться» говорить голосом любого человека, если у них есть образцы речи. Сейчас нужно буквально 30 секунд вашей речи: это может быть отрывок из соцсетей или вам позвонят с безобидным опросом. Нейросеть клонирует тембр, голос, уникальные черты. Многие скажут: «Я всегда отличу голос сына/дочери». Это верно, если вы знаете и насторожены, но когда звонок ночью, и там правдивые факты – эмоции берут верх.

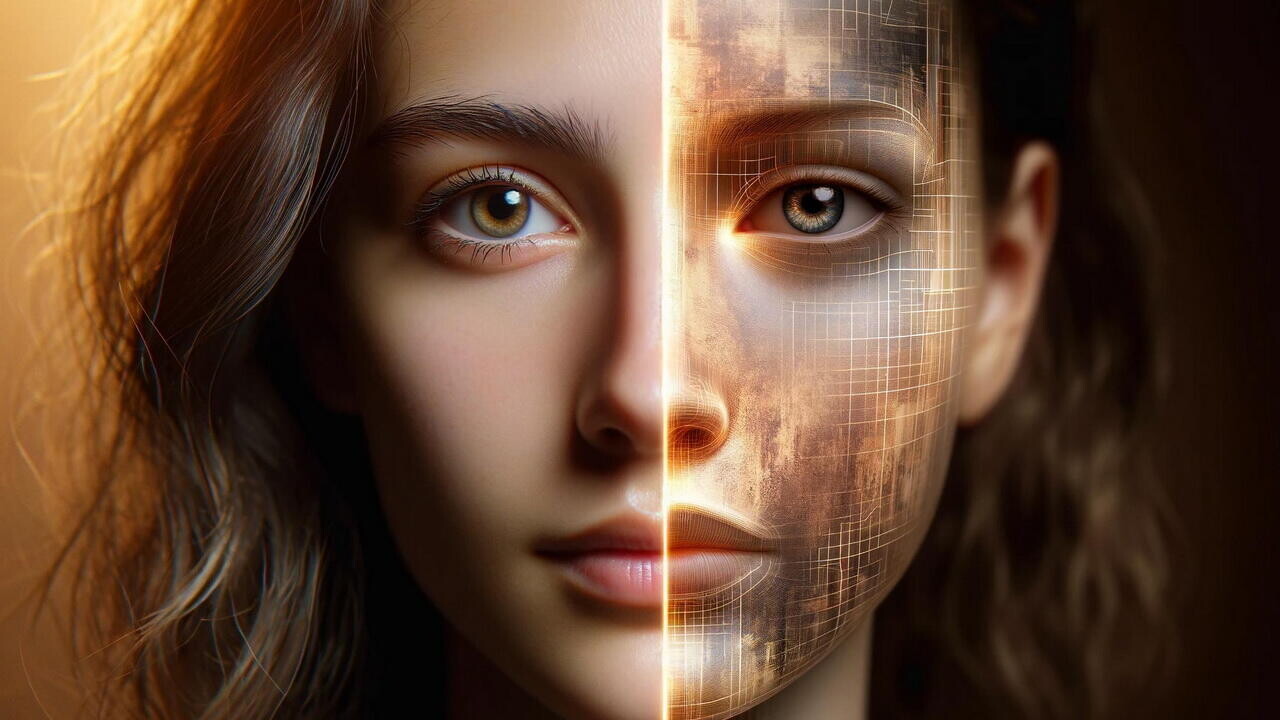

3. Видеодипфейки (Real-Time Deepfake и Face Swap).

Помимо аудио, мошенники используют технологии наложения «чужого» лица на видеозапись в реальном времени. Так возникают «видеозвонки» от мэров, генералов, знаменитостей или руководителей компаний, которые просят срочно перевести средства. Убедительность достигается за счет точной синхронизации движений губ и мимики с синтезированным голосом. Мы делаем много переводов знаменитых англоязычных лекций по этой технологии, и 30 % зрителей пишут: «Когда Маск так хорошо выучил русский язык?» Это говорит о том, что качественную подделку мозг сначала воспринимает как оригинал.

4. Генерация текстов (Large Language Models, ChatGPT, подобные системы).

Языковые нейросети сделали революцию – с их помощью можно писать статьи, посты, помогать ребенку в учебе, вести диалог… и, конечно, подделывать стиль нужного человека. Для этого нужно дать входные данные: авторские статьи, факты о человеке или просто его активный профиль в соцсетях – система быстро понимает паттерны и подстраивается. В качестве эксперимента мы обучили модель на статьях известного блогера Kokoby – через 10 минут система писала уже «шекели, кокобаи».

Таким образом, ИИ-технологии дали не только прогресс в бизнес-процессах, но и возможность злоумышленникам массово тиражировать реалистичные подделки, от документов и банковских квитанций до голосовых звонков и видеотрансляций. Мошенники и раньше с помощью входа в доверие могли уводить крупные суммы денег, но теперь их арсенал только увеличился, к сожалению. И теперь мы должны принять важный постулат текущей эры:

Ни голос, ни внешность, ни стиль разговора в цифровой среде никак не могут служить доказательством, что перед вами – настоящий человек. Теперь это с нами навсегда.

1. Поддельные документы и фальшивые переводы

1.1. «Новый паспорт за одну минуту».

С появлением генеративных нейросетей фальсифицировать документы стало проще: в даркнете за 15 долларов появились сервисы (например, OnlyFake) для мгновенной генерации фото поддельных паспортов и водительских прав любой страны. Мошенники берут чужие ФИО и фото из соцсетей, вставляют в шаблон – и получают реалистичный «документ», который умудряется проходить проверку на разных онлайн-сервисах. С такими подделками успели оформить не один микрокредит на имя жертвы, оставив людей с долгами. Банки не успевают блокировать подобные фальшивки: ИИ штампует их слишком быстро.

1.2. Фейковые чеки и квитанции.

Генерация поддельных скриншотов банковских переводов – еще один трюк. Указываешь сумму, время, реквизиты – и нейросеть «рисует» идеальный скрин, будто деньги действительно ушли. На онлайн-площадках полно историй, как продавец поверил такому скриншоту и отдал товар, не дождавшись реального поступления. Например, россиянка лишилась 75 000 ₽, думая, что ей действительно перевели оплату. Только позже она поняла, что «скрин» был искусной подделкой, а перевод не поступал.

1.3. «Деньги переведены – вот пуш-уведомление…»

Часто мошенники при личной встрече показывают «выполненный перевод» на экране телефона. Вы можете даже увидеть якобы пришедшее уведомление о зачислении. Но на деле это приложение с поддельным интерфейсом (сгенерировать такую «оболочку» для Android или нарисовать фейковое push-сообщение несложно при помощи нейросети). Продавец радуется, отдает товар – а денег никогда не увидит.

В Москве таким образом продавец объектива «увидел» поступление 150 тыс. руб. на счет, но реальных средств не дождался. Пока выяснял правду, покупатель уже скрылся.

2. Deepfake-звонки: от «Мама, помоги!» до видеочата с чиновником

2.1. «Мама, помоги мне!»

В США мать получила звонок от якобы похищенной дочери, которая плакала и умоляла спасти ее. Голос звучал точь-в-точь как у дочери. Злоумышленник потребовал выкуп. К счастью, мама успела проверить, что ребенок в порядке, и вычислила обман. Оказалось, преступники сгенерировали голос девочки с помощью ИИ – им хватило пары записей из соцсетей.

2.2. Дипфейк-клон в FaceTime: у китайского предпринимателя «друг» выманил миллионы.

В мае 2023 года предприниматель из Китая получил видеозвонок от давнего приятеля. Тот умолял срочно занять 4,3 млн юаней (около 620 тыс. долларов) «для залога по сделке». Мужчина перевел деньги, но потом оказалось, что настоящий друг ничего не просил. Мошенники применили deepfake-технологию в реальном времени: лицо и голос подделали под знакомого. К счастью, полицию удалось оперативно подключить, и часть денег вернули.

2.3. «Видеозвонок» от мэра и генерала – афера на 2 млн.

В 2024 году преподавательнице из Подмосковья позвонили в видеочате… мэр Москвы Сергей Собянин и замглавы МВД Александр Горовой. По крайней мере так это выглядело. На экране действительно были узнаваемые лица, синхронно произносившие тревожную речь о том, что на ее счета покушаются мошенники. Женщине велели срочно снять деньги и «передать их под охрану». Итог – минус 2 млн рублей. Как выяснилось, преступники использовали дипфейки лиц высокопоставленных чиновников и грамотно сыграли на страхе.

2.4. «Мама, это я… срочно нужны деньги».

В России в 2023–2024 годах зафиксирована волна звонков пожилым людям от «внуков/детей», которые якобы попали в ДТП и им срочно нужна помощь. Теперь голос даже не приходится имитировать актеру – за него говорит нейросеть, обученная на записях настоящего родственника. Родители слышат вроде бы своего сына и без сомнений переводят деньги.

Изображение сделано за 20 секунд, при должной мотивации и цели его можно многократно приблизить к реалистичности. Но вопрос в другом: что подумает мама в 12 часов ночи, получив звонок моим голосом и такое фото, зная, что я в дороге? Нейросети – это последнее, что она подумает.

2.5. Имитация голосов сотрудников банка и полиции.

Классическая афера «Вам звонят из банка: срочно спасайте средства» с помощью ИИ вышла на новый уровень. Теперь голос менеджера или следователя может звучать один в один как у реального человека, которого вы когда-то слышали (например, ранее разговаривали с этим специалистом). Сыграет и «видеозвонок с полицейским», если мошенники заморочатся с дипфейком. В результате жертва, даже обладая опытом, порой не отличает, что на связи – ненастоящий сотрудник.

3. Атаки на бизнес: фальшивый босс, приказы ФСБ и виртуальные заложники

3.1. «Одолжите миллион – говорит директор».

В 2020-м менеджер банка в Гонконге получил звонок от «директора головной компании», который велел перевести 35 млн долларов для неотложной сделки. Голос совпадал с голосом босса. Позже выяснилось, что это аудио – deepfake. Деньги ушли преступникам, а случай стал одним из громких примеров ИИ-атаки на бизнес.

3.2. Когда звонит «сам начальник» (Великобритания).

Схема

В 2019 году глава фирмы перевел мошенникам 200 000 фунтов, услышав в телефоне голос своего босса из штаб-квартиры. После первого успешного перечисления аферисты попросили еще, но тут бухгалтеры насторожились: на дисплее высветился австрийский номер. Оказалось, голос руководителя был синтезирован нейросетью.

3.3. «Говорит ваш шеф…» в России.

В 2023 году вспыхнула волна подобных же историй: сотрудникам компаний звонил «гендиректор» с требованием срочно перевести крупную сумму. Но теперь голос звучит убедительно, а для пущей солидности мошенники добавляют «приказы ФСБ» или любые другие липовые документы, которые тоже генерирует нейросеть (логотипы, печати, подписи). Всё это создает эффект «официальной операции». В ряде случаев фирмы теряли миллионы, пока не научились проверять каждое распоряжение напрямую.

3.4. Виртуальный «захват заложников».

Были даже попытки инсценировать, будто офис компании захвачен неизвестными. Руководству включали «стрим» с гендиректором (deepfake), который просил выкуп за сотрудников. Понадобилось время, чтобы удостовериться: в реальности всё в порядке, никто не захвачен – это была кибератака, соединенная с дипфейк-видео. Но представьте себе стресс и панику внутри компании!

(Конкретные подробности этого кейса широко не освещались в СМИ, но специалисты по кибербезопасности упоминают подобные инциденты в корпоративных учениях.)

3.5. «Атака на миллион по голосу директора».

В 2023-м особенно участились случаи, когда мошенники собирают данные о фирме и ее боссе, взламывают или подделывают мессенджер гендиректора, затем бухгалтерия получает сообщение (или звонок) о срочной оплате «проверки» или «штрафа». Голос – знакомый, фразочки – как у босса. В результате компания теряет значительные суммы.

4. Романтические аферы и LoveGPT

4.1. Фальшивые партнеры, созданные нейросетью.

Теперь на сайтах знакомств легко нарваться не на живого человека, а на «робота», который выглядит и общается почти идеально. Мошенники создают учетные записи с красивыми фото (сгенерированными нейросетью) и подключают ChatGPT – подобный бот для переписки. «Виртуальная девушка» или «парень» ведет долгие беседы, делится «личными воспоминаниями» и вызывает доверие. Как только жертва «влюбляется», ее начинают раскручивать на деньги: просят оплатить билет, или купить что-то на фишинговом сайте, или просят срочной материальной помощи.

Пример

В 2023–2024 годах было несколько случаев, когда люди переводили «возлюбленному из интернета» крупные суммы (сотни тысяч рублей), а потом выяснялось, что с ними разговаривал бот LoveGPT – преступники только контролировали последние этапы, где нужно сказать: «Спасибо, солнышко, ты спас(-ла) меня!»

5. Сексторшн и шантаж репутацией

5.1. «Порноподделки» для шантажа.

Мошенники могут взять ваше обычное фото из соцсетей и с помощью нейросети «раздеть» вас, сгенерировать убедительное видео откровенного характера, а потом требовать деньги: «Заплати, иначе разошлем твоим родственникам и коллегам». В Индии был случай, когда преступники сделали дипфейк-порноролик 76-летнего пенсионера (использовали образ отставного полицейского) и заставили его несколько раз платить «за молчание».

5.2. «Шантажист 2.0»: «Мы сфабрикуем доказательства против тебя».

Иногда злоумышленники угрожают создать фальшивую аудиозапись (или видео), где жертва якобы признается в преступлении. С нейросетью такой «компромат» звучит крайне правдоподобно. Затем мошенники пишут: «Заплатишь – или отправим это в полицию». Подобные случаи пока не повсеместны, но технология уже есть, и это следующий виток шантажа.

6. Взлом аккаунтов и рассылка дипфейков друзьям

6.1. «Друзья, выручайте! Мне срочно нужны деньги!» – история с Алтая.

В Барнауле у девушки Марины злоумышленники взломали Telegram, скачали ее фото и голосовые сообщения, а затем сгенерировали видеообращения, где «она» умоляет друзей дать взаймы. Пятеро знакомых поверили и перевели в сумме 100 000 рублей. Марина ничего не знала: ее цифровой двойник рассылал интимные детали, говорил точно ее голосом. Лишь позже выяснилось, что это дипфейк.

Похожая история в Твери. 25-летней девушке взломали мессенджер, сгенерировали ее голос и разослали всем контактам сообщение: «Пожалуйста, одолжи 5000 рублей до зарплаты, очень нужно!» К счастью, владелица аккаунта успела предупредить знакомых, и деньги почти никто не отправил. Но факт остается фактом: преступникам достаточно парочки голосовых заметок, чтобы научить ИИ говорить как вы.

6.2. «Deepfake-друзья» в Туле.

В Туле у мужчины украли Telegram, собрали из личных видео и аудио нейродвойника и разослали «кружочки» – короткие видео с его лицом и голосом, где он просит занять денег. Несколько человек отправили суммы от 7 до 30 тыс. рублей. Только когда один из друзей заметил несоответствие в реквизитах, жертвы поняли, что это фейк.

7. Фишинг 2.0: письма и сообщения, которые пишет ИИ

7.1. Идеальные «официальные» письма.

Схема

Раньше фишинговые сообщения выдавали себя косноязычными формулировками. Но с помощью ChatGPT можно быстро настрочить безукоризненные тексты от лица «банка» или «директора». Их даже персонализируют под конкретного адресата. По данным RTM Group, такие гибридные атаки (взлом почты + грамотные письма от ИИ) достигают 40 % эффективности. Сотрудник видит письмо «от босса», где всё выглядит правдоподобно: стиль, грамотность, детали. И переводит деньги на «нужды компании».

7.2. Ловушки под видом «эксклюзивного доступа к ChatGPT»

Когда в РФ ChatGPT был официально недоступен, мошенники запустили фейковые сайты «продажи аккаунтов». За небольшую сумму предлагали «легальный» доступ к популярному ИИ-боту. На деле люди оставляли там платежные данные, которые тут же использовались злоумышленниками. Любой громкий запуск новой технологии – повод для афер.

8. Поддельные инвестиции и лжеуслуги под ИИ

Это скриншот из рекламы в моем Instagram – знаменитый артист уверенно рекламирует услуги сомнительной компании и даже не в курсе об этом. Но я уверен, десятки людей «повелись» на авторитет знаменитого человека.

8.1. «Илон Маск рекомендует…» – видео, которого не было.

Имя Илона Маска чаще всего используют в дипфейках о чудесных криптоинвестициях. В 2023 году появились десятки роликов, где «Маск» обещает удвоить вложения и зовет на платформы-однодневки. Люди верят глазам, ведь перед ними вроде бы сам миллиардер. В итоге вклады тают бесследно, а каналы с этими видео блокируют, но мошенники выпускают новые.

8.2. Продажа фейковых акций DeepSeek.

В 2025 году аферисты запустили лживые сайты, где якобы можно купить акции китайской нейросети DeepSeek до ее IPO. Людей манили обещанием огромной прибыли. На деле, подключая кошелек к такому «инвестсервису», жертва теряла все средства. Или покупала «токены» DeepSeek, которые нельзя перепродать. Компания DeepSeek никаких акций не выпускала, а махинаторы нажились на хайпе.

8.3. Запретный AI-адвокат.

В Казахстане мошенники сделали дипфейк-видео известного юриста, где он «рекламирует» услугу по возврату денег у мошенников. Люди обращались за помощью, платили «гонорар» на указанные реквизиты и оставались ни с чем. Сам юрист оказался шокирован: его цифровой двойник ходил по соцсетям, обещая несуществующие услуги. Полиции было непросто: формально лицо и голос совпадали с реальным адвокатом, который сам и подавал жалобу.

9. Мошенничество в туризме: липовые отели и бронирования

9.1. Фейковые гостиницы с AI-фотографиями.

На платформах типа Booking появлялись красивые объекты размещения, которых не существует в реальности. Фото – сгенерированы нейросетью, отзывы тоже написаны ботом. Туристы бронировали и оплачивали номера, а по приезде обнаруживали либо пустое место, либо вовсе другой отель. Администрации сайта удалось удалить часть таких фальшивых объявлений, но до этого мошенники заработали тысячи евро.

Что в итоге?

Мы видим целый спектр опасных схем – от поддельных документов до реалистичных дипфейков в видео и аудио. Проблема уже не в том, что «есть где-то нейросети», а в том, что ими активно пользуются преступники. Поэтому любой «экстренный» звонок или сообщение, любая «выгодная» инвестиция, любой «официозный документ» теперь требует двойной проверки.

- Не доверяйте звонку только потому, что голос (или даже лицо в видео) знакомое.

- Всегда проверяйте поступление денег фактически, а не по картинке.

- Не переходите по «левым» ссылкам: взлом аккаунта – короткий путь к дипфейкам от вашего имени.

- Если слышите от «босса» или «чиновника» что-то слишком срочное – свяжитесь с ними по другим каналам.

- Будьте готовы к тому, что даже фото- или видеодоказательства могут оказаться фальшивкой.

К сожалению, с прогрессом технологий мошенники еще быстрее будут их внедрять, их рентабельность позволяет это делать быстрее, чем средства защиты. Поэтому первое, что нужно делать – быть осведомленным о новых способах и рассказать об этом вашим родным и близким.